La figura e l’opera di Kurt Gödel hanno subito una singolare fortuna, comune del resto al lavoro di molti grandi pensatori i cui risultati travalican

La figura e l’opera di Kurt Gödel hanno subito una singolare fortuna, comune del resto al lavoro di molti grandi pensatori i cui risultati travalicano i confini di una singola disciplina e si diffondono all’interno del patrimonio culturale collettivo. Come è accaduto ad esempio con la relatività einsteniana, e anzi in stretta connessione con questa, anche i contributi di Gödel sono stati avvolti da una confusa aura mitologica che ne ha spesso autorizzato semplificazioni, parafrasi e forzature che ne tradiscono il senso profondo. Del resto, anche molti matematici, attivi in aree diverse dalla logica formale, hanno una conoscenza piuttosto approssimata dei risultati di Gödel e l’idea che in genere se ne ha è che essi fissano dei “limiti” alle capacità razionali della mente umana (versione popolare), o più concretamente alle impostazioni assiomatiche nella formalizzazione delle teorie (versione del matematico “medio”). Entrambe le versioni mostrano una percezione piuttosto limitata della magistrale lezione di Kurt Gödel e soprattutto del modo che questi aveva di intendere il suo lavoro.

Una prova della vitalità dei famosi teoremi di indecidibilità del grande pensatore la si trova ad esempio sul recente e ancora non concluso dibattito sulle possibilità e i limiti delle teorie sull’intelligenza artificiale, e nella ricerca appena iniziata di una teoria generale dei sistemi complessi logicamente aperti, in relazione alla loro capacità di produrre informazione sintattica e semantica.

Per comprendere il ruolo svolto dal lavoro di Gödel all’interno di questi nuovi sviluppi è necessario considerare brevemente i problemi fondazionali della matematica all’inizio del novecento. Il grande matematico D. Hilbert aveva suggerito la possibilità di configurare l’intera conoscenza matematica attraverso l’uso del metodo assiomatico, ossia utilizzando un numero finito di proposizioni di partenza in grado di definire astrattamente gli enti della teoria, gli assiomi A, ed un insieme di regole di inferenza R. Sia A che R sono espressi in un linguaggio sintatticamente preciso ed a-semantico, un insieme di simboli e di operatori per la loro manipolazione.

Utilizzando le regole R è possibile generare i teoremi T della teoria dagli assiomi A. Un sistema di questo tipo si dice sistema formale <L,A, R>, e deve possedere una serie di requisiti generali:

1) Coerenza o non-contraddittorietà: un sistema formale non può produrre assieme una proposizione P e la sua contraddizione non-P;

2) Completezza sintattica: un sistema formale si dice completo quando, data una qualsiasi proposizione P formata secondo L , è possibile dimostrare che può essere ricavata da A utilizzando le regole R;

3) Decidibilità: un sistema è decidibile se data una proposizione P è possibile dimostrare in un numero finito di passi se la proposizione appartiene o meno al sistema utilizzando R

4) Assiomatizzabilità: un sistema <L,A,R> è assiomatizzabile se è possibile mostrare che un sistema <L,A,R>* che produce gli stessi teoremi T di <L, A, R> , è decidibile. In altre parole, si richiede di poter fare il percorso inverso della decidibilità, individuando gli assiomi A a partire dai teoremi T;

5) Ricchezza: un sistema formale si dice sintatticamente ricco se è possibile associare a ogni proposizione generale P relativa alle proprietà di una certa classe di oggetti, una proposizione particolare P1 che riguarda un membro particolare della classe che esibisce effettivamente quelle proprietà. Ci si aspetta che un sistema formale possa esplorare in modo esauriente ogni oggetto costruibile tramite <L, A, R>.

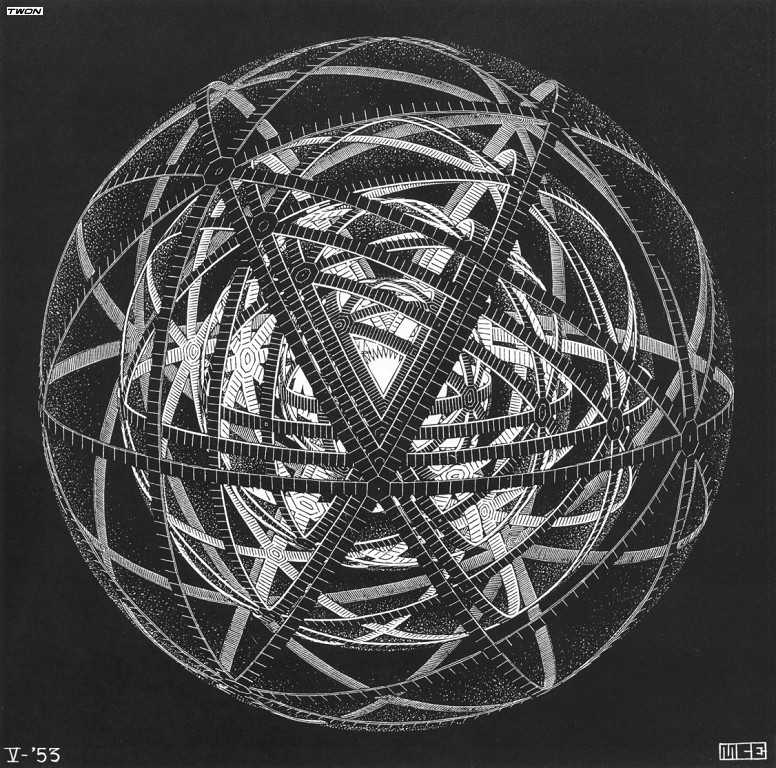

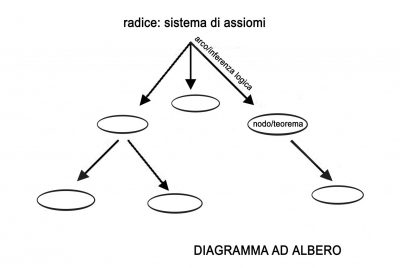

È interessante notare che l’idea dell’assiomatizzazione ha un legame piuttosto stretto con la visione meccanicistica della natura. Infatti gli assiomi A possono essere visti come gli stati iniziali di un sistema fisico, le regole R come le leggi di evoluzione di un sistema fisico e i teoremi T gli stati del sistema che si succedono a quelli iniziali durante l’evoluzione. Come un sistema fisico deterministico “fissa” tutti i suoi stati una volta scelte le condizioni iniziali e le leggi di evoluzione, così un sistema formale è “potenzialmente” contenuto nell’insieme A e da esso ricavato tramite l’applicazione “meccanica” delle R. Come più tardi il lavoro di Alan M. Turing (1936) chiarirà, il senso dell’aggettivo “meccanico” può essere specificato utilizzando la nozione di Turing-computabilità come caratterizzazione della decidibilità. E più tardi, R. Solomonoff e G. Chaitin mostreranno che la richiesta di assiomatizzabilità equivale a sostenere la possibilità di compressione algoritmica di una certa quantità di informazione. È possibile farsi un’idea intuitiva delle proprietà dei sistemi formali utilizzando un particolare tipo di grafo detto diagramma ad albero, costruito in questo modo :

Useremo le seguenti convenzioni: la radice rappresenta il sistema di assiomi A, i nodi i teoremi T ed in generale le proposizioni ricavabili da A attraverso le regole R, la cui applicazione è simboleggiata dagli archi che legano i nodi tra loro ed alla radice. In questa rappresentazione la non-contraddittorietà richiede all’albero di non esibire insieme i rami speculari di un bivio logico, il nodo e l’antinodo; la decidibilità e l’assiomatizzabilità riguardano la possibilità di collegare i nodi alla radice e viceversa , mentre la ricchezza e la completezza hanno a che fare con la possibilità dell’albero di raggiungere più nodi possibili attraverso una configurazione abbastanza ampia e articolata. L’estensione indica la capacità dell’albero di accrescersi e complessificarsi. In questo caso è possibile che la radice originaria si trasformi in un nodo della nuova configurazione estesa.

I Teoremi di incompletezza e indecidibilità di Gödel

Gran parte dell’attività sui fondamenti della matematica nel ‘900 riguarda lo studio di una particolare classe di sistemi formali, quelli sufficientemente potenti. Si tratta di quei sistemi che sono qualcosa di più che un semplice “giocattolo” logico, e che hanno una complessità strutturale almeno equivalente a quella dell’aritmetica naturale. In pratica, tutte le teorie formali interessanti, tra cui quelle fisiche- matematiche, rientrano in questa categoria. I sistemi sufficientemente potenti hanno una notevole capacità auto-referenziale, sono cioè in grado di produrre proposizioni che riguardano la loro struttura interna, cosa dalla quale dipende la loro “fecondità” .

I teoremi di Gödel (1931) fissano dei limiti molto precisi al programma di Hilbert, sviluppato ad es. nei poderosi “Principia Mathematica” di B. Russell e A. North Whitehead (1910 -1913), mostrando che i sistemi formali “pagano” questa grande capacità espressiva con complicazioni logiche di natura radicale:

Primo teorema di Gödel: Ogni sistema sufficientemente potente, coerente ed assiomatizzabile è sintatticamente incompleto.

Questo risultato esprime che è sempre possibile produrre a partire da un sistema di assiomi A una proposizione P indecidibile, ossia della quale è impossibile stabilire, con gli strumenti del sistema, la verità o la falsità. Nel contesto teorico offerto dalla Macchina di Turing questo equivale al famoso problema della fermata (halting problem): non esiste alcun programma (algoritmo) generale che applicato a una particolare coppia (programma-argomento) sia in grado di stabilire a priori se la computazione relativa alla coppia considerata terminerà o meno.

Secondo teorema di Gödel: Ogni sistema sufficientemente potente, coerente e assiomatizzabile è incapace di dimostrare una proposizione che esprima in modo canonico la coerenza dello stesso sistema.

In un certo senso, la limitazione di questo teorema è ancora più drastica della prima. Il teorema afferma infatti che utilizzando gli strumenti sintattico-formali di <L, A, R> è impossibile dimostrare la “solidità” logica del sistema stesso e in particolare prevedere la produzione di uno sviluppo contraddittorio. La speranza riposta da Hilbert nel metodo assiomatico come strumento per la “sicurezza” di una fondazione logica del sapere matematico veniva così minata alle radici. Come scrive lo stesso Godel nell’incipit del suo famoso lavoro: “La tendenza della matematica verso un sempre maggiore rigore ha portato, come è ben noto, alla formalizzazione di suoi ampi settori, così che al loro interno è possibile dimostrare un teorema usando solo poche regole meccaniche. I sistemi formali più ampi elaborati sino a questo momento sono quello dei Principia Mathematica (PM), e il sistema di assiomi di Zermelo-Fraenkel per la teoria degli insiemi (con i successivi sviluppi di J. Von Neumann). Questi due sistemi sono talmente generali che tutti i metodi dimostrativi attualmente impiegati in matematica sono stati formalizzati al loro interno, cioè ridotti a pochi assiomi e alcune regole di inferenza. Si potrebbe quindi supporre che questi assiomi e queste regole siano sufficienti a decidere ogni quesito matematico formalmente esprimibile in essi. Si dimostrerà più avanti che non è così, e che al contrario esistono nei due sistemi citati problemi relativamente semplici riguardanti la teoria dei numeri naturali che non possono venire decisi sulla base degli assiomi.[…] (Kurt Gödel, “Sulle proposizioni formalmente indecidibili dei Principia Mathematica e di sistemi affini”, trad.it. di P. Pagli, in S. G. Shanker (a cura di), Il teorema di Gödel, trad. it. di P. Pagli, Franco Muzzio Editore, Padova, 1991, pp.23 –25).

Se il primo teorema di Gödel mostra la possibilità per le strutture formali di entrare in un circolo vizioso a proposito della verità di una particolare proposizione, il secondo investe l’intera affidabilità logica del sistema. Un sistema sufficientemente potente può sembrare coerente fino a prova contraria, ma non è possibile saperlo a priori. L’impossibilità di dimostrare la propria solidità logica non esclude infatti di poter produrre una proposizione in grado di mostrare un’incompatibilità che riguarda lo stesso cuore assiomatico della struttura. Utilizzando la rappresentazione del diagramma ad albero, i teoremi limitativi affermano che è possibile, per un dato nodo, non poter costruire alcun percorso in grado di connettere il nodo all’albero (decidibilità), e che non è possibile, considerando lo sviluppo della configurazione, escludere la produzione di rami speculari (coerenza).

I risultati di Gödel, considerati globalmente, ci mettono davanti a un dilemma epistemico: le teorie di grande ricchezza espressiva, sufficientemente articolate al punto da essere in grado di esibire una certa capacità di auto-descrizione, non possono offrire garanzie della loro coerenza, altrimenti sono soggette a singolarità indecidibili. In particolare, il secondo teorema evidenzia l’impossibilità di bloccare il regresso ad infinitum nella catena fondazionale delle meta-teorie. La coerenza del sistema, infatti, se non può essere dimostrata con gli strumenti interni della teoria, richiederà l’utilizzazione di proposizioni metateoriche, cosa che ha poi stimolato lo sviluppo delle posizioni bourbakiste, che limitano le loro ambizioni a una caratterizzazione assiomatica delle teorie algebriche e topologiche, utilizzando l’impostazione assiomatica come “strumento organizzativo” piuttosto che come garanzia di “perfezione” logica .

La matematica come sistema aperto

La sua evidente importanza ha fruttato al secondo teorema di Gödel una grande fama, seguita da una serie di indebite estrapolazioni filosofiche che tendevano a vedere scritta in questa dimostrazione uno scacco ineludibile non soltanto dei procedimenti di formalizzazione ma addirittura un’espressione matematica dei limiti stessi della ragione umana. Restando nell’ambito delle strutture formali, il problema posto dai teoremi enunciati è molto più definito: qual è il numero minimo di ipotesi necessarie per rendere coerente un sistema formale? Studiando proprio il sistema formale “modello”, ossia quello dell’aritmetica naturale, è stato possibile stabilire che non è sempre necessario uscire “fuori dal sistema” per garantirne la consistenza.

Basterà integrarlo con opportune proposizioni che in pratica vanno a rafforzare il sistema senza modificarlo, fornendo gli elementi strutturali necessari per far si che una parte della teoria, insieme alle nuove proposizioni, sia in grado di produrre la dimostrazione di coerenza dell’intera struttura formale opportunamente estesa. Utilizzando l’immagine del grafo ad albero tutto questo equivale ad innestare alcuni rami senza modificare la configurazione originaria, fornendo i percorsi logici minimali necessari per una dimostrazione di solidità. È chiaro che non esiste un metodo standard per costruire un’estensione e non esiste neppure alcuna certezza di riuscirci. Si tratta di un’arte raffinata che richiede una grande creatività matematica e una conoscenza profonda della struttura che si sta esaminando.

È opinione diffusa sostenere che i teoremi di Gödel rappresentino per l’intera matematica una sorta di spada di Damocle sospesa sull’intero corpus della conoscenza formale: da un giorno all’altro potrebbe manifestarsi qualche proposizione indecidibile, o peggio, qualche contraddizione fondamentale in grado di invalidare tutto a un livello profondo. Naturalmente, come suggerisce il metodo delle estensioni formali, questa opinione non rispecchia per niente quello che effettivamente fanno i matematici e rivela invece un’incomprensione radicale dell’insegnamento del lavoro di Gödel. Le teorie matematiche producono effettivamente delle proposizioni indecidibili, ed è possibile trovarne diverse in punti cruciali della conoscenza matematica. Ma, lungi dal creare una situazione di stallo, opportunamente studiate diventano nodi fecondi, capaci di generare nuova matematica.

Un esempio elementare e universalmente noto è quello del cosiddetto “assioma delle parallele”. Nel sistema della geometria euclidea appare molto naturale la proposizione: “Per un punto esterno ad una retta passa una e una sola retta parallela alla prima”. Euclide e centinaia di successori provarono a dimostrare questa asserzione partendo dagli altri assiomi, ma senza alcun risultato. La posizione di questo “teorema” sembrò incerta fino alla fine del ‘700 ed i primi dell’ 800, quando il lavoro di Gauss, Bolyaj, Lobachevskij e Riemann mostrò che in realtà si trattava di un assioma e che dunque non poteva essere dedotto. Il metodo usato per ottenere questa nuova comprensione fu particolarmente costruttivo: si suppose che per un punto esterno a una retta data potessero passare più di una parallela (assioma di Lobachevskij), oppure nessuna (assioma di Riemann). Il procedimento non generò alcuna falla logica, e anzi produsse due nuove geometrie non-euclidee, rispettivamente quella iperbolica e quella ellittica, quest’ultima usata poi da Hilbert e da Einstein per la descrizione dello spaziotempo curvo della relatività generale.

Va osservato che i matematici sanno bene che certe antinomie si presentano soltanto come casi-limite e dunque, all’interno di una certa serie di procedure, è possibile continuare a usare tranquillamente strutture che potenzialmente contengono delle contraddizioni, come la ben nota teoria intuitiva degli insiemi. Osservazioni analoghe possono essere fatte per il problema della coerenza generale delle teorie formali. Di fatto non si teme giornalmente che lo sviluppo autonomo di sistemi formali diversi possa portare a una specie di collisione. È vero piuttosto il contrario: è proprio lo studio dei “ponti di connessione” tra strutture diverse che in genere produce la matematica più interessante. Tutto questo ci conduce alla lezione più profonda che i teoremi di Gödel ci danno sulla natura della matematica: lungi dall’essere un’enorme gioco tautologico costituito da un’insieme di procedimenti meccanici durante i quali ogni proposizione si trasforma continuamente in altre in una catena infinita di equivalenze, la matematica è un sistema aperto, in grado di generare sempre nuovi problemi, un albero che si arricchisce continuamente di nuovi imprevedibili rami. Può essere interessante studiare un’analogia tra sistemi fisici e teorie matematiche, in relazione a questo carattere di apertura che è messo in luce dai teoremi di Gödel. Un sistema in grado di accrescersi e rinnovarsi, produrre “novità” ed “emergenze”, deve avere una forma di apertura logica, che è una condizione diversa dalla semplice apertura termodinamica, che nel caso dei sistemi formali può essere interpretata come la possibilità per l’informazione sintattica che esprime assiomi e teoremi di essere soggetta a forme di deriva e riorganizzazione in relazione all’assetto globale del sistema di conoscenza. Ad esempio, un teorema nuovo può stabilire delle connessioni tra rami della matematica prima lontani – è accaduto recentemente con il teorema di Fermat! – e dunque molti risultati parziali ne escono “ridimensionati”, ma anche più strettamente connessi tra loro (grafi scale-free). Si tratta, in qualche misura, di un processo di accrescimento simile all’autopoiesi ipotizzata per i sistemi viventi da Maturana e Varela. Quando si tenta di “comprimere” la conoscenza in un sistema assiomatico “si perde sempre qualcosa”. Nello sviluppo “naturale” della matematica, i risultati si conservano, riorganizzandosi continuamente in virtù delle nuove acquisizioni.

Kurt Gödel ed Albert Einstein a Princeton

L’impatto dei teoremi di Gödel nel dibattito sull’intelligenza artificiale

Il lavoro di Gödel ha avuto un forte e controverso impatto sugli aspetti teorici dell’ IA. Se consideriamo infatti un sistema di IA “forte”, basato sulla manipolazione simbolica e implementato tramite funzioni Turing-computabili, è possibile considerarlo a tutti gli effetti un sistema formale, ed è dunque possibile chiedersi il significato dei teoremi di indecidibilità in relazione alla possibilità di realizzare un sistema di questo tipo. Lo stesso Gödel affrontò il tema in occasione della “Conferenza Gibbs”, tenuta il 26 dicembre 1951, ponendo una serie di questioni sulle quali, com’era sua abitudine, ritornò più volte.

Ricordiamo che l’IA era già nell’aria: nel dopoguerra, anche grazie ai contributi di figure del calibro di Von Neumann, buon amico di Gödel, i calcolatori avevano cominciato la loro inarrestabile crescita; la conferenza di Dartmouth sarebbe avvenuta solo nel 1956, ma era già forte un’attività di contributi e comunicazioni tra coloro che ne sarebbero stati i protagonisti; Turing, che nel 1937 aveva ideato il suo famoso schema teorico per la definizione di “numeri calcolabili”, aveva pubblicato l’anno prima il suo brillante e provocatorio lavoro “Computing Machinery and Intelligence”.

Gödel iniziò la sua conferenza riconoscendo subito una profonda connessione tra i suoi risultati e quelli di Turing, e anzi sottolineò come il lavoro di Turing avesse svolto un’opera di chiarificazione. Ma aggiunse subito che questi contributi non dovevano essere presi come uno scacco della mente umana, ma piuttosto come una limitazione precisa dei sistemi formali. A questo proposito introdusse una distinzione tra proposizioni matematiche obiettivamente vere e proposizioni vere in relazione ad un sistema formale, sostenendo che le capacità della mente umana di gestire le prime non era in alcun modo limitata dai teoremi relativi al secondo tipo di proposizioni. Del resto, proseguì, in linea di principio nulla vieta di considerare la possibilità di una “macchina intelligente”, e ammise che era possibile trovare una qualche somiglianza tra il cervello e un automa finito, per quanto gli sembrasse che i risultati delle neuroscienze negassero “fermamente” la possibilità di spiegare i processi mentali in termini puramente meccanici.

Se così fosse, sicuramente un automa finito andrebbe incontro a questioni indecidibili, ma anche la mente umana si trova in questo tipo di situazioni. La differenza sostanziale è che la mente umana può sempre escogitare nuove strategie per superare queste difficoltà, mentre un automa no. La fede di Gödel nell’inesauribilità della mente e della matematica erano basate in un suo platonismo critico e moderato, che lo portò infine a sostenere che “O la mente umana oltrepassa infinitamente la potenza di ogni macchina finita, o altrimenti devono esistere problemi diofantini insolubili in modo assoluto”. La seconda parte della conferenza fu centrata proprio su questa professione di fede platonica nelle verità matematiche che lo portava ad ribadire il suo scetticismo nei confronti di ogni tentativo di ridurre l’attività matematica ad un gioco di convenzioni sintattiche, come voleva in fondo il programma di Hilbert.

Gli appunti di Gödel in margine al testo originale della conferenza – che non fu mai pubblicata nella versione originale – mostrano che il grande logico e filosofo era convinto di non aver addotto argomenti abbastanza stringenti e che era necessario lavorare ancora a lungo su questi problemi, cosa che cominciò a fare subito dedicandosi ad un saggio centrato sulla confutazione della filosofia di R. Carnap, ed intitolato “La Matematica è una sintassi del linguaggio?”.

Sembra dunque evidente che per Gödel l’idea di fondo dell’IA non era una preoccupazione principale. Quello che davvero gli stava a cuore era cercare di comprendere la natura dell’attività matematica e della mente. Le tesi dell’IA, ed in particolare quella oggi nota come tesi di Church-Turing che sostiene la possibilità di simulare qualunque processo mentale tramite funzioni Turing-computabili, sembravano ingenue alla sua sensibilità filosofica, ma come logico era perfettamente consapevole che i suoi argomenti non erano ancora abbastanza forti. È interessante notare che Gödel non prese alcuna posizione nel dibattito provocato, ad esempio, dall’articolo “anti IA” del filosofo J.R.Lucas , “Mind, Machines and Gödel” (in Philosophy, 36, 1961), centrato proprio sulla possibilità di un sistema logico-formale di “restare in scacco” davanti a una proposizione indecidibile ottenuta con la procedura di Gödel. Questa tesi è stata recentemente ripresa dal fisico-matematico R. Penrose, nel suo fortunato libro “La Mente Nuova dell’Imperatore”(ed it. Rizzoli, 1992). Rispondere all’articolo di Lucas fu la spinta principale per D. R. Hofstadter nella scrittura del monumentale e controverso “Gödel, Escher, Bach: un’Eterna Ghirlanda Brillante”(ed. it. Adelphi,1984), libro che sicuramente ha almeno il merito di aver fatto conoscere le idee di Gödel ad un largo pubblico.

Soltanto nel 1969, riflettendo sulle parole dell’ormai scomparso Turing, gli sembrò di aver trovato la giusta obiezione. Nel suo lavoro del 1936, Turing aveva scritto (a proposito della possibilità di paragonare la mente a un automa finito) che “la giustificazione consiste nel fatto che la memoria umana è necessariamente limitata”. Secondo Gödel ciò che Turing aveva trascurato è che “la mente nel suo uso, non è statica, ma si sviluppa costantemente (…) Quindi, benché a ogni stadio del suo sviluppo il numero dei suoi stati possibili discernibili sia finito, non c’è motivo per cui questo numero non possa divergere all’infinito nel corso di questo sviluppo” (dichiarazione ad Hao Wang ,cit. in Dawson, pag.247). È vero che in una sua lettera “teologica” alla madre Gödel sostiene che questa capacità di ampliare la sfera della nostra comprensione in modo potenzialmente illimitato si estende anche al di là della morte, confermando così i fondamenti metafisici della sua critica, ma questa osservazione è comunque abbastanza pregnante da poterci offrire, anche alla luce degli sviluppi recenti dell’IA, la possibilità di una sua formulazione scientifica. Come dichiarerà anche al matematico e scrittore Rudy Rucker (R. Rucker, comunicazione personale, 1998), l’idea di Gödel era che noi potremmo effettivamente costruire una macchina pensante basata su un gruppo di assiomi di partenza, ma che durante l’interazione con l’ambiente, per via di elementi casuali, questa poteva complessificarsi a tal punto da sfuggire alla nostra analisi e modificarsi strutturalmente in modo impredicibile (idea sulla quale più tardi Rucker costruirà il suo romanzo “Software”, 1982). In altre parole, sembra che a Gödel fosse chiaro che la capacità di produrre novità, intuizioni, strategie, acquisire comprensione ed apprendere, tipiche della mente umana, poco o nulla avessero a che fare con le proposizioni indecidibili dei sistemi formali. Certo, un meccanicista convinto potrebbe sempre trovare il modo di spiegare un comportamento umano sulla base di un’opportuna gerarchia di Macchine di Turing, ma questo è cosa ben diversa dalla capacità di produrre quei comportamenti. Il problema non consiste dunque tanto nella possibilità di “stare dentro o fuori dalle regole del gioco”, quanto nella possibilità della mente di cambiare continuamente le regole del gioco (per una riflessione epistemologica vedi Licata, 2008). Infatti le architetture “classiche” dell’ IA simbolica “forte” hanno mostrato di essere logicamente chiuse, e hanno riportato successo soltanto in micro mondi semanticamente limitati, mentre la mente umana è logicamente aperta ed in grado di produrre nuova informazione e nuove regole, caratteristica ben rispecchiata dai modelli distribuiti sub-simbolici connessionisti e bio-morfi, come le reti neurali.

Nella stessa direzione era andato Turing nel dopoguerra. È del 1950 il famoso Computing machinery and intelligence in Mind 59, 433–460, dove partendo dalla constatazione che ogni uomo è stato un bambino, si introduce l’idea delle child machines che si complessificano nell’interazione con l’ambiente e segnatamente con la cultura in cui la mente è immersa (“the human community as a whole”). Il lavoro sulla morfogenesi poi conferma non soltanto un interesse antico per la biologia ma suggerisce un’aspirazione ad individuare modelli effettivi di crescita e differenziazione per le macchine bambine. Tutto questo ci indica che la mente artificiale sarà meno “meccanica” di quanto si continui a pensare (l’eccentrica idea di “singolarità tecnologica”, secondo la quale ciò che ieri era ferraglia si trasforma per magia esponenziale in mente autonoma) e sarà verosimilmente basata su modelli in grado di implementare un alto grado di apertura logica. Se questo avverrà, sarà affascinante chiedersi, in una versione rinnovata del test di Turing, se le macchine saranno in grado di gestire incertezza e fare scommesse sul mondo.

Fonte: L’ Indiscreto.org